China endurece las medidas en contra de los deepfakes e implementa una de las primeras regulaciones de su tipo sobre este peligro. Además, aumenta el control del país sobre el contenido de internet.

China endurece las medidas en contra de los deepfakes e implementa una de las primeras regulaciones de su tipo sobre este peligro. Además, aumenta el control del país sobre el contenido de internet.

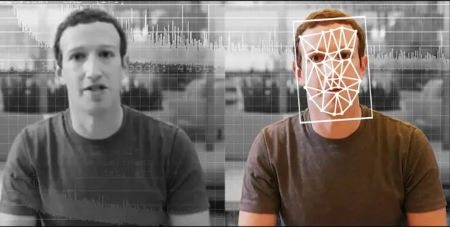

Los deepfakes son herramientas que utilizan la inteligencia artificial para crear o manipular imágenes o vídeos alterados o generados sintéticamente. Por ejemplo, se puede crear un discurso falso de algún presidente de gobierno o hacer publicidad sin utilizar actores reales.

- La nueva ley para regular los deepfakes y frenar la desinformación

Provisions on the Administration of Deep Synthesis of Internet Information Services es es el nombre de la nueva legislación, creada para proteger a las personas de la suplantación digital de su voz o su imagen sin consentimiento. Entra en vigor este 10 de enero de 2023.

Una de sus regulaciones es que los usuarios deberán dar su consentimiento para que su imagen se utilice en cualquier tecnología. Además, estos servicios no pueden hacer uso de esta herramienta para difundir noticias falsas.

«Se requiere que los proveedores de servicios de deepfakes y los asistentes técnicos fortalezcan la gestión de datos de capacitación y la gestión técnica. Además de que garanticen la seguridad de los datos, prohíban el procesamiento ilegal de información personal. Que revisen, evalúen y verifiquen periódicamente los mecanismos de algoritmos», menciona el boletín.

Por otra parte, los servicios de Deepfake necesitan autenticar la identidad real de los usuarios. El contenido modificado deberá tener alguna etiqueta o aviso de que ha sido alterado mediante esta herramienta. «Los servicios que brindan funciones como diálogo inteligente, voz humana sintetizada, generación de rostros humanos y escenas realistas inmersivas que generan o cambian significativamente el contenido de la información, se marcarán de manera destacada para evitar la confusión pública o la identificación errónea».

Los expertos en este tipo de tecnología aseguran que la ley aborda dos objetivos: una censura en línea más estricta, y adelantarse a la regulación en torno a las nuevas tecnologías.

Kendra Schaefer, socia con sede en Beijing de la consultora Trivium China, señaló a CNBC que «lo interesante es que China está apuntando a una de las amenazas críticas para nuestra sociedad en la era moderna: la erosión de la confianza en lo que vemos y escuchamos, y la creciente dificultad de separar la verdad de las mentiras».

Henry Ajder, asesor en IA generativa, asegura que tener la responsabilidad, ya sea como usuario final o como plataforma, de etiquetar contenido falso, probablemente sea algo en lo que tengamos que empezar a confiar.

Henry Ajder, asesor en IA generativa, asegura que tener la responsabilidad, ya sea como usuario final o como plataforma, de etiquetar contenido falso, probablemente sea algo en lo que tengamos que empezar a confiar.

- China aborda la parte negativa pero ¿y la positiva?

Esto tiene su parte positiva y negativa. En la parte positiva, por ejemplo, encontramos MyHeritage. Esta herramienta permite «dar voz» a los familiares de fotos antiguas para animar los rostros de las fotografías con expresiones o movimientos que parecen realistas.

La parte negativa es que los vídeos y las imágenes son muy realistas, lo que puede llevar a desinformación, confusiones, estafas y fraudes. Cualquiera que tenga un ordenador y acceso a internet puede crear un deepfake.

Por ejemplo, hace un mes apareció un deepfake del actor Morgan Freeman donde podemos ver «al actor» hablando. Su voz, su cara, todo nos hace pensar que es el real hasta que nos demuestran lo contrario.

China no es la única que se planteó crear nuevas regulaciones de los deepfakes. Tanto los gobiernos de Reino Unido, Taiwán y de EE.UU. anuncian su intención de prohibir la creación de vídeos pornográficos creados con esta herramienta.